Retrouvez toutes nos autres videos sur notre chaîne YouTube.

Si vous avez aimé notre précédent article, rédigé par Aurélia, sur l’explicabilité des modèles, vous serez certainement intéressé par ce nouvel article qui présente en particulier une nouvelle approche méthodologique pour améliorer l’interprétation de modèles de Deep Learning, souvent très opaques. Il s’agit de la méthode des « Integrated gradients », qui a été introduite en 2017.

En effet, les algorithmes d’apprentissage automatique sont de plus en plus vus comme des “Black Box” non compréhensibles par les humains, ce qui pose un problème de confiance et de transparence vis à vis des décisions prises par les machines. C’est ainsi que la nécessité de pouvoir expliquer des décisions prises par ces algorithmes devient de plus en plus importante et affecte plusieurs domaines.

À titre d’exemple, dans le domaine médical on aimerait savoir sur quoi est basé la décision d’un modèle qui détecte la présence d’une maladie asymptomatique chez un patient. Un autre exemple type se trouve dans les sociétés proposant des services d’abonnements à leurs clients. En général, ces entreprises utilisent des algorithmes qui prévoient la résiliation des contrats. Dans ce cadre, l’objectif de l’explicabilité sera de savoir sur quoi l’algorithme s’est basé pour détecter une potentielle résiliation de contrat, ce qui permettra par la suite de mieux adapter l’offre d’abonnement à la demande.

1. Opacité et transparence

Les algorithmes de Machine Learning peuvent être divisés en deux parties différentes : Les algorithmes transparents et les algorithmes opaques.

Les algorithmes transparents sont ceux qui sont explicables de nature. La régression linéaire ou logistique, l’arbre de décision, l’algorithme des k plus proches voisins (k-NN), le modèle additif généralisé ainsi que le modèle bayésien sont des algorithmes transparents et compréhensibles de nature.

Par contre, les forêts aléatoires, les SVM et toute la famille des réseaux de neurones profonds (incluant les réseaux de neurones convolutionnels et les réseaux de neurones récurrents) sont des algorithmes opaques qui nécessite une méthode d’explicabilité afin de rendre leurs décisions compréhensibles par les humains.

2. Méthodes d’Explicabilité

Plusieurs méthodes d’explicabilité ont vu le jour durant ces dernières années, chacune d’entre elles ayant ses propres avantages et inconvénients. On peut principalement les diviser en deux grandes catégories [1]: les méthodes agnostiques et les méthodes spécifiques.

2.1. Méthodes Agnostiques

Les méthodes agnostiques désignent celles qui peuvent s’appliquer à tous les types de modèles. Les méthodes agnostiques les plus populaires sont LIME [2] et SHAP [3]. La méthode LIME consiste à transformer le modèle complexe en un modèle linéaire simple au voisinage d’un point de donnée. L’avantage de cette méthode est sa simplicité et sa rapidité d’exécution. Son inconvénient est l’instabilité des explications et la définition du « bon voisinage ».

La méthode SHAP est basée sur le calcul des valeurs de Shapley. En plus de sa simplicité d’interprétation, son réel avantage est qu’elle repose sur une théorie mathématique assez solide. Son inconvénient est que le calcul des valeurs de Shapley est très complexe pour des problèmes réels, juste une approximation de ces valeurs est possible. Un autre inconvénient est le fait qu’elle ne prend pas en compte la corrélation entre les features du modèle. En revanche, de nouvelles variantes [4] permettent de résoudre ce problème en se basant sur la théorie des copules.

2.2. Méthodes Spécifiques

À l’opposé des méthodes agnostiques, les méthodes spécifiques sont des méthodes conçues pour un type de modèle bien précis. À titre d’exemple, « DeConvNets », « Guided back-propagation », « Deeplift » et « Integrated Gradients » (IG) sont des méthodes spécifiques pour l’explicabilité des réseaux de neurones. Par la suite, on explicitera la méthode IG ainsi que ses applications dans différents types de réseaux de neurones.

3. Integrated Gradients (IG)

Integrated Gradients [5] est une nouvelle méthode d’explicabilité basée sur le calcul des gradients et conçue pour toute la famille des réseaux de neurones (réseaux profonds, réseaux convolutionnels, réseaux récurrents et réseaux à base de transformeurs).

3.1. Formulation

Soit ![]() une fonction représentant un réseau de neurones,

une fonction représentant un réseau de neurones, ![]() une donnée d’entrée et

une donnée d’entrée et ![]() une donnée de référence. On considère le segment reliant

une donnée de référence. On considère le segment reliant ![]() à

à ![]() , et on calcule le gradient en tout point de ce segment. La méthode IG consiste tout simplement à sommer ces gradients. Ainsi, IG dans la ième dimension, est donné par la formule suivante :

, et on calcule le gradient en tout point de ce segment. La méthode IG consiste tout simplement à sommer ces gradients. Ainsi, IG dans la ième dimension, est donné par la formule suivante :

(1) ![]()

L’avantage que IG a sur les autres méthodes existantes est qu’elle satisfait les deux axiomes de la sensibilité et de l’invariance d’implémentation qu’on détaille dans le paragraphe suivant.

3.2. Axiomes

3.2.1. Axiome de la sensibilité

Une méthode d’explicabilité satisfait la sensibilité si pour toute donnée d’entrée et de référence qui ne diffèrent qu’au niveau d’une seule feature, cette méthode donne une attribution non nulle à cette feature chaque fois que les prédictions respectives associées à la donnée d’entrée et à la référence sont différents.

En d’autres termes, si ![]() représente une donnée d’entrée,

représente une donnée d’entrée, ![]() une donnée de référence,

une donnée de référence, ![]() une fonction de réseau de neurone et

une fonction de réseau de neurone et ![]() une méthode d’attribution où

une méthode d’attribution où ![]() mesure la contribution de

mesure la contribution de ![]() dans la prédiction

dans la prédiction ![]() , alors :

, alors :

![]() si

si ![]() alors

alors ![]()

où ![]() =(0…0 (k) 0…0)

=(0…0 (k) 0…0)

↑

ième position

k étant un réel non nul.

Notons que les méthodes d’attributions comme « LIME », « DeConvNets » et « Guided back-propagation » ne satisfont pas l’axiome de la sensibilité.

3.2.2. Axiome de l’invariance d’implémentation

Deux réseaux de neurones sont dits fonctionnellement équivalents si leurs sorties sont les mêmes pour toute donnée d’entrée, même si leurs architectures sont différentes. Une méthode d’attribution satisfait l’axiome de l’invariance d’implémentation si les attributions sont identiques pour deux réseaux fonctionnellement équivalents.

À noter que les méthodes d’attributions DeepLift et LRP utilisées pour les réseaux de neurones convolutionnels violent l’axiome de l’invariance d’implémentation.

3.3. Applications

3.3.1. Reconnaissance d’objet

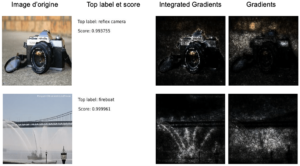

L’application de la méthode IG sur une tâche de reconnaissance d’objet [5] en utilisant un réseau de neurones d’architecture GoogleNet entrainé sur le dataset ImageNet donne le résultat suivant :

La comparaison avec la méthode du gradient montre une nette différence au niveau de l’explicabilité.

3.3.2. Question-Réponse appliquée à l’image

La méthode d’IG a aussi été appliquée à la tâche « Visual Question-Answering ». Cette dernière consiste à poser une question sur une image donnée, et à obtenir la réponse à partir du modèle prédictif. Le modèle utilisé est celui développé dans [2]. Il traite la tâche de « Question-Answering » comme une tâche de classification où les classes sont les 3000 réponses les plus fréquentes dans le dataset d’entrainement. L’exemple suivant illustre l’application de l’IG sur ce modèle. Les couleurs rouges représentent une attribution positive, les couleurs bleues représentent une attribution négative et les couleurs grises une attribution proche de zéro.

Question : how symmetrical are the

white bricks on either side of the

building

Prediction: very

Ground truth: very

3.3.3. Analyse de Sentiment

La méthode IG peut aussi être appliquée à des architectures basées sur des transformeurs comme BERT. L’exemple suivant [7] illustre son application sur une tâche d’analyse du sentiment utilisant le modèle BERT. La couleur rouge suggère une attribution négative tandis que la bleue dénote une attribution positive.

“This was not a bad movie” ; Prédiction : Positive

Conclusion

Dans cet article, on a présenté une méthode d’explication des modèles de deep learning qui s’appelle « Integrated Gradients ». L’avantage de cette méthode, par rapport à ses concurrentes, est qu’elle satisfait les deux axiomes de la sensibilité et de l’invariance d’implémentation.

De nouvelles variantes basées sur le calcul du gradient sont récemment sorties comme le smoothGrad [8] qui améliore la sensibilité du gradient (en moyennant sur plusieurs valeurs du gradient) ou encore, la méthode Generalised Integrated Gradients (GIG) [9] qui généralise l’utilisation de l’IG à d’autres types d’algorithmes de Machine Learning.