IA et Éthique

Retrouvez toutes nos autres videos sur notre chaîne YouTube.

Dans le monde, 2.5 quintillions (10³⁰) bytes de données sont générés par jour en moyenne. La quantité de données produite ne cesse d’augmenter. Dans l’univers de l’intelligence artificielle, ces données sont une ressource primaire alimentant des algorithmes de plus en plus performants ayant des applications très diverses, de la publicité ciblée à la recherche fondamentale. À l’instar d’un musicien travaillant ses gammes, ces algorithmes sont entraînés, encore et encore, à partir des données, à : prévoir, catégoriser, reconnaître, ou même « créer », et chaque secteur, publique ou privé, y voit un intérêt. Ainsi, là où il y a des données, il y aura des algorithmes pour les utiliser, parachevant l’élan donné par l’essor de l’informatique quelques décennies auparavant.

L’intelligence artificielle et la faculté de comprendre

On pourrait définir l’intelligence artificielle (IA) par l’ensemble des techniques visant à imiter ou simuler l’intelligence humaine. Pour l’heure, si l’on se concentre sur les modèles de machine et de deep-learning, ces techniques tirent surtout leur nom d’une forme de biomimétisme algorithmique, mais sont très loin de ressembler aux capacités cognitives d’un être humain. Nous prendrons alors la définition de ceux qui l’ont pensée :

“The science of making machines do things that would require intelligence if done by men. It requires high-level mental processes such as: perceptual learning, memory and critical thinking.” / “La construction de programmes informatiques qui s’adonnent à des tâches qui sont, pour l’instant, accomplies de façon plus satisfaisante par des être humains car elle demandent des processus mentaux de haut niveau tels que : l’apprentissage perceptuel, l’organisation de la mémoire et le raisonnement critique” M. Lee Minsky

“The ability of machines to execute tasks and solve problems in ways normally attributed to humans” / “La capacité des machines à exécuter des tâches et résoudre des problèmes d’une manière normalement attribuée à des humains” Y. Lecun

L’intelligence artificielle a donc intrinsèquement un rapport au remplacement de certaines tâches, non triviales, humaines, par des techniques informatiques. C’est parce qu’elle excelle dans l’accomplissement de celles-ci que l’on pourrait se méprendre sur ses capacités. Il est ainsi important de résoudre l’ambivalence liant ces algorithmes et l’humain. L’intelligence artificielle peut accomplir des tâches complexes souvent mieux qu’un humain, à l’instar de l’IA de détection du cancer du sein développée au sein du MIT [1], mais elle ne dispose pas de la faculté de comprendre ni de celle de découvrir, contrairement à l’être humain. Pour autant, la part des applications de l’IA dans notre quotidien ne cesse d’augmenter et on estime que 47%[2] des emplois aux États-unis pourraient être remplacés par des machines et des algorithmes. Du caissier aujourd’hui au taxi demain, le remplacement des humains par des machines interpelle sur la notion de travail, mais aussi sur celle de responsabilité. Est-il finalement si anodin de remplacer les tâches humaines par de l’IA ?

Une intelligence artificielle peut-elle être responsable ?

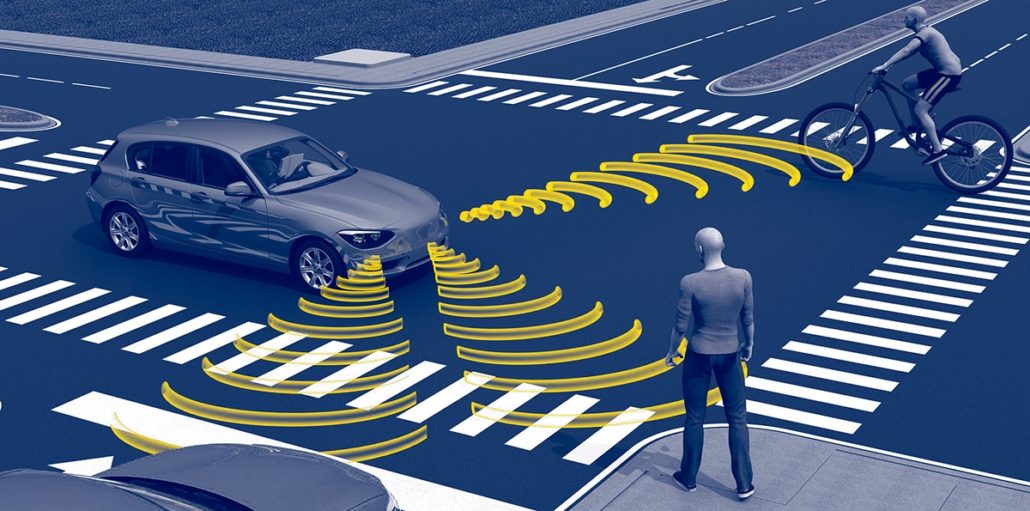

Les passagers ? Le piéton ? Et qui est responsable ?

Lorsque nos voitures n’auront plus besoin de pilote, qui sera responsable d’un accident ? Comment un véhicule prendra-t’il la « meilleure » décision, entre percuter un mur et risquer la mort des passagers, ou risquer celle de piétons ? Y a-t-il même une meilleure décision dans ces cas-là ?

Nous différencions ici la notion de prise de décision de celle de la responsabilité d’une intelligence artificielle. La première est un processus complexe qui consiste à choisir parmi l’étendue des actions permises pour répondre à une situation donnée. Or, comme nous l’avons vu, l’IA est bornée, limitée par son architecture, ses paramètres, ou encore ses données d’entraînement. D’autre part, dénuée de morale ou même de pragmatisme, l’intelligence artificielle n’est pas en capacité de prendre ce genre de décision. Ces décisions sont donc dictées par l’homme, c’est ainsi qu’en Allemagne une commission éthique [3] a proposé une série de règles telles que :

- Dans l’éventualité d’un accident, aucune discrimination (âge, sexe etc.) ne saurait être appliquée entre les individus

- La vie humaine prime sur le reste (dégât matériel, vie animale…)

Ces règles imposent un pragmatisme, une morale que nos sociétés établissent pour appréhender les situations imaginées. Ainsi, les algorithmes d’intelligence artificielle ne prennent pas de décisions ; ce sont des décisions dictées en amont. De ce fait, il y a une certaine prédétermination à l’œuvre dans les évènements provoqués par une intelligence artificielle et c’est probablement cet aspect qui rend l’appréciation de la responsabilité si compliquée. Pour être juridiquement responsable, une intelligence artificielle devrait pouvoir répondre de son comportement.

À ce jour, malgré la création de commissions de réflexion quant aux nouveaux défis juridiques (AI4EU, AI HLEG)[4,5], le droit Français est encore inadapté à traiter de dommages provoqués par une intelligence artificielle. Plusieurs pistes sont cependant considérées.

Le droit commun est séparé entre droit contractuel et droit extracontractuel. Dans le premier cas, il suffit que l’une des parties défaille aux termes du contrat pour établir une faute. Il n’y a ainsi pas de difficulté liée à l’identification de la responsabilité [6].

Dans le cadre du droit extracontractuel la réparation fait suite à un dommage, que ce dernier soit provoqué volontairement ou non, le responsable doit en assumer les conséquences. Dans ce cadre juridique, si le dommage est provoqué par une “chose” sans qu’une volonté (humaine) de nuire ne lui soit associée, comme lorsqu’une machine dysfonctionne, c’est alors au gardien de l’objet de répondre des dégâts causés [7]. Ainsi, lors de l’explosion d’une chaudière sur un semi-remorqueur ayant provoqué la mort d’un ouvrier travaillant à son bord, la justice a-t-elle reconnue la responsabilité du propriétaire du semi-remorqueur au motif que l’on est “responsable du fait des choses que l’on garde” (Arrêt dit Franck, 2 décembre 1941).

Mais dans le cadre de l’intelligence artificielle, si cette dernière n’est certainement pas considérée comme une personne, elle n’est pour autant que le moteur d’une chose. Si nous reprenons l’exemple des voitures autonomes, l’intelligence artificielle n’est pas l’objet causant le dommage, c’est en fait le véhicule, l’objet matériel qui blesse. De fait, il y a plusieurs “gardiens” envisageables : le conducteur et propriétaire de l’objet mais aussi le concepteur de la voiture, qui est souvent également le détenteur de la licence intellectuelle liée à l’intelligence artificielle. Si les procédés juridiques permettent de partager la responsabilité entre plusieurs propriétaires d’un objet, il ne semble pas souhaitable de systématiser cette solution. En effet, l’intelligence artificielle s’adapte et continue d’apprendre de l’usage qu’en fait son utilisateur. Si la façon dont l’IA doit réagir aux inputs de l’utilisateur dépend du concepteur du programme, l’autonomie qui lui est laissée n’empêche pas l’utilisateur d’en faire un mauvais usage, de manière répétée, changeant potentiellement les données d’apprentissage du modèle. Ainsi, Tay, chatbot développé par Microsoft, s’est rendu célèbre pour entretenir un discours raciste [8] du fait de ses dialogues avec ses utilisateurs. Des détournements similaires pourraient donc se produire aussi avec les voitures autonomes ce qui rendrait la responsabilité des possibles gardiens difficile à déterminer en cas d’accident.

Il y a de fait une certaine prudence à observer lorsque l’on rend un jugement en invoquant le droit commun, car la moindre décision peut ensuite faire jurisprudence et risquer ainsi de modifier le droit établi pour tous les jugements futurs [9]. Ainsi, si la notion de gardien est mal utilisée dans un jugement, ce dernier peut être révisé en appel ou en cassation, ce qui, à son tour, peut amener à réviser la définition de gardien en général.

Ainsi, les initiatives les plus prometteuses semblent plus s’orienter vers la création de régimes juridiques propres aux nouvelles technologies. En 2012, l’état du Nevada a ainsi mis en place un cadre législatif dédié aux véhicules autonomes. Le cadre prévoit 5 niveaux de responsabilité, considérant les différents degrés de liberté décisionnelle du véhicule et donc de son intelligence artificielle. Le niveau 0 caractérise l’absence d’autonomie, auquel cas c’est le conducteur qui est responsable, tandis que le niveau 5 représente une autonomie complète, entraînant la responsabilité du constructeur. En 2016, l’Europe a modifié la Convention de Vienne qui stipulait que tout véhicule devait avoir un conducteur, suggérant que les outils juridiques commencent à se mettre en place en vue de préparer l’arrivée des objets autonomes. En l’état, il reste encore beaucoup de zones d’ombre qu’il appartient aux juristes d’éclairer, cependant il est permis d’être optimiste quant à la survenue prochaine d’outils adaptés à notre quotidien transformé. Suivant les recommandations du livre blanc traitant l’intelligence artificielle [10] édicté par la commission européenne, le parlement européen vient d’adopter la proposition d’Axel Voss appelant à “l’adaptation d’un cadre de responsabilité civile tourné vers l’avenir, avec une responsabilité stricte pour les IA à haut risque”. Pour celui-ci, la responsabilité en cas de dommage devrait être imputée aux opérateurs de systèmes d’IA.

Finalement, l’intelligence artificielle fait partie de notre quotidien, elle conduit à des prouesses qui en font une avancée majeure dans nombre de domaines. Et s’il est sûr qu’elle accompagnera notre futur, il est nécessaire de prendre conscience de sa “nature”, et ainsi se poser les bonnes questions pour appréhender les défis que soulèvera la place de l’intelligence artificielle dans nos sociétés.